RTX 4090のリファレンスモデルから適切な電力設計を読み解く

「NVIDIA GeForce RTX 4090 Founders Edition」の電力設計を考察します。

消費電力、VRMフェーズ数、MOSFETの性能、GPUとVRAMの電圧などを確認し、NVIDIA謹製のリファレンスモデルのベールを明かしていきます。

この記事の目的は、主にグラフィックボードの「適正な消費電力」を計算することです。

RTX 4090の消費電力は450Wですが、これに見合った電力設計になっているかを確認します。

リファレンスモデルは比較的マニアックな品物で、オリジナルモデルを買う方が大半だと思います。

オリジナルモデルは採用しているVRMフェーズが違うため、電力周りの設計は各社異なります。

リファレンスモデルの中身を紐解けば本来あるべき設計が見えてくるというロジックです。

結論を述べると、リファレンスモデルの適正な消費電力はGPUが367.5W、VRAMが70.875Wです。

これに対して実測の最大消費電力はGPUが375.6W、VRAMが72.7Wであったため、リファレンスモデルは適正値にかなり近いことが分かりました。

この観点からグラボをレビューした記事がなかったので書きました。

なお、私はPCパーツ関連の知識はありますが、工学に自信はありません。

変なことを言っていたらTwitterでご指摘ください。

ちなみにNVIDIA自身が製造・販売するグラフィックボードが「リファレンスモデル」です。

それに対して、NVIDIA以外が販売するグラフィックボードを「オリジナルモデル」と呼びます。

後者はものによってオリジナルファンモデル(オリファン)などと呼ばれたりもします。

RTX 4090 Founders Editionのカタログスペック

NVIDIA GeForce RTX 4090 Founders Edition (RTX 4090 FE) のスペックです。

RTX 4090自体の性能については他サイトの方が詳しいので多くは記載しません。

本記事と関係のあるところだけ抜粋します。

| 標準メモリ構成 | 24 GB GDDR6X |

| グラフィックス カード電力 (W) | 450 W |

| 補助電源コネクタ | PCIe 8 ピン ケーブル x 3 (アダプター付属) または 450W 以上の PCIe Gen 5 ケーブル |

TGPが450Wで、メモリはGDDR6Xを使っているところがポイントです。

公式サイトに記載はありませんが、電力制限を解除することで最大600Wまで電力を引き上げられます。

PCIe 8ピンケーブルは1本辺り最大150Wの供給なので、3本で接続する場合、電力制限を解除するのは危険です。

電力制限を解除する場合は600WのPCIe Gen 5 ケーブル(12VHPWR)を接続してください。

2023年時点で12VHPWRには対応していない電源ユニットがほとんどですが、RTX 4090 Founders Editionに付属している変換アダプターは12ピンを8ピン×4に変換できるので、従来の電源ユニットにも接続できます。

12VHPWRケーブルは電源ユニットに同梱されていたり、別途発売されていたりします。

配線の取り回しなどの都合で変換したくなかったり、新しい電源ユニットを買いたくない場合はCORSAIRの「PCIe Gen5 12VHPWR cable」を買うといいでしょう。

ちなみにグラフィックボードはマザーボードに接続しますが、マザーボードのPCI Express×16スロットから給電できるのは75Wまでなので、450Wには到底足りません。

そこで必要になるのが補助電源コネクタです。

これはグラフィックボード-電源ユニット間をケーブルで接続するので、電源ユニットから直接電力を供給できます。

GPUチップとVRAMチップの消費電力

450Wの内訳は何なのでしょうか?

The FPS Reviewのレビュー記事を参考にしてみます。

| GPU-ZのSensors | センサーの意味 | 電力1(※1) | 電力2(※2) | 電力3(※3) |

|---|---|---|---|---|

| Board Power Draw | 全体の消費電力 | 435.6W | 430.3W | 444.8W |

| GPU Chip Power Draw | GPUの消費電力 | 357W | 356.1W | 375.6W |

| MVDDC Power Draw | VRAMの消費電力 | 70.4W | 72.7W | 68.3W |

※1 ゲーム:Cyberpunk 2077、ディスプレイ:4K、設定:Psycho Ray Tracing

※2 ゲーム:Dying Light 2、ディスプレイ:4K、設定:Ultra Ray Tracing

※3 ゲーム:Metro Exodus Enhanced、ディスプレイ:4K、設定:Extreme Ultra Ray Tracing

計測にはGPU-Zが使用されています。

このほか、計測時のGPUの電圧が1.05Vであることも記載されています。

センサーはPWR_SRCなど他にもあるのですが、それらは調べてみてもよく分かりませんでした。

Board Power Draw以外を足せばBoard Power Drawになるかと思いきやそうではないので、回路上の都合でGPUやVRAMに使う電力をセンサーが拾っていたり、ファンやNVENCやPCIeスロットなどの他の部品の電力が入っていたり、またセンサーで計測できない部分もあって一概には言えないのかもしれません。

GPUとVRAMに焦点を当てている以上、本筋から外れてしまうので厳密な追及はしません。

最も大きなBoard Power Drawは444.8Wです。

RTX 4090は標準だと450Wで動作するので、概ね合っています。

450W設定の場合、恐らく最大でGPUは380W程度、VRAMは75W程度までは消費し得るのでしょう。

380W+75W=455Wで450Wを超えますが、Board Power DrawはTGPを超えることもあるため、それ自体は不思議ではありません。

なお、GeForceには電力データ取得用のAPIがあり、それに対応したソフトウェア(GPU-ZやHWiNFO)はAPIを元に近似値を取得しているため、信憑性が高いと言える情報です。

しかし、結論から言ってしまえば、PCATを使わなくてもGeForce系の消費電力はかなり近い値を把握できる。その理由は、NVIDIAがPCATに先立ちGeForce用ドライバーに詳細な電力データ獲得用のAPIを実装しているためだ。お馴染みの「GPU-Z」や「HWiNFO」がこのAPIに対応しているので、誰でも調べられる。

ビデオカードの消費電力を正確に計測するNVIDIAの純正キット「PCAT」と「FrameView」を解説 (4/5)

あくまで参考値

消費電力は計測環境によって変動があります。

The FPS Reviewの記事のデータを見れば分かる通り、ゲームやゲーム内の設定によって違います。

重いゲームを動かすためにGPUが頑張るので、その分消費電力が上がっているということです。

GPUに負荷がかかっていてもVRAMに負荷がかかっていないパターンでは、GPUの消費電力が上がってもVRAMはそこまで上がりません。

逆にVRAMをたくさん使うゲームや作業ならVRAMの消費電力が上がります。

使用している電源ユニットの性能(どれほど安定した電力を供給しているか)などでも結果が変わります。

センサー読みの値もあくまで"近似値"です。

もっと言えばマザーボードも関係していますし、GPUに対してCPUが弱ければGPUはそこまで頑張れないので、CPUによっても結果が変わります。

サーマルスロットリングまで考えると、ケースのエアフローや部屋の温度にも左右されますね。

細かいことは言いっこなしです。

データが信用できない、という話をしているわけではありません。

"正しい計測データ"を過信しないようにしよう、ということです。

計測環境によって変わり、また厳密な値ではないことは頭の片隅に入れておきましょう。

VRMフェーズ

VRMフェーズはチョーク、コンデンサ、MOSFET、ドライバICの組み合わせで構成される部品です。

これらは電源ユニットが供給する電圧を、チップが求める電圧に変換します。

電源ユニットは家庭用電源(日本では通常100V)を3.3V、5V、12Vなどの電圧に変換しますが、GPUやVRAMはそれぞれ異なる電圧で動作するので、それに合わせてさらに変換する必要があるからです。

ただ変換を行うだけでなく、適切な電圧・電流に素早く調整して供給することが重要な役割です。

最近のCPU VRMは出力電圧は1Vでも電流は100Aになったりする。Power MOSFET単体の大出力化にも限度はあるし、仮に実現できたとしても大電流を1つのスイッチング回路で流すのでは発熱も大きくなるし、応答性も悪化する。

応答性とは、CPUの負荷変動に応じて出力電流を調整する能力のことで、電源のキモとなる部分である。負荷が増えると、当然ながら多くの電流が必要になる。どんな電源でも高い負荷がかかると電圧低下が起きるのだが、応答性が悪いとその時間が長くなり、装置の動作に悪影響が出る。さらに、負荷が減ってからも大きな電流を流し続けて、電圧が上がり過ぎて装置を壊すということもある。VRMのマルチフェーズ化によって、応答性を確保しつつ大出力化にも対応できる。

マザーボードのフェーズの話 - PC Watch

上記はマザーボードのVRMフェーズに関する記述ですが、グラフィックボードも同様です。

CPUもグラフィックボードも年々消費電力が増えていき、今やマルチフェーズが当たり前でフェーズ数もとても多くなっています。

特にグラフィックボードはインフレ度合いが高いです。

早い話が、VRMフェーズは多い方がいいということです。

グラフィックボードのVRMフェーズの性能や数は公開されていません。

レビューサイトや有志が分解して公開した基板、評価した内容から判断するしかありません。

自分で分解して確認するのが理想ですが、1台30万円とかするグラボをわざわざ買って分解するのは無理of無理

判断材料には何があるでしょうか?

試しに調べてみましょう。

VRMフェーズの数

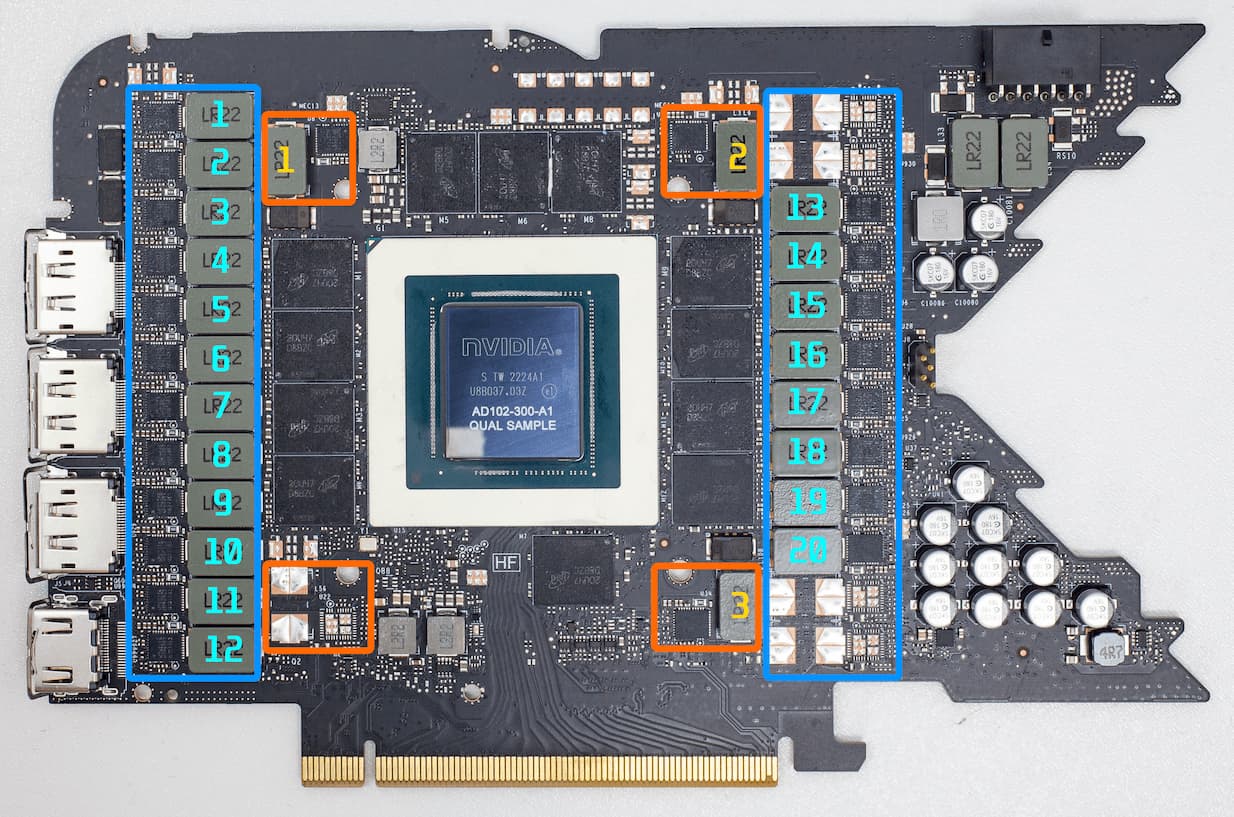

基板を見れば一目瞭然です。

青枠がGPUチップ用、オレンジ枠がVRAMチップ用です。

より拝借した画像にVRMフェーズの枠と数字を追加(すみません、コンデンサが枠に入っていませんね……)

枠で囲っている中に、VRMフェーズが実装されていない空白の箇所もありますね。

リファレンスモデルをオリジナルモデルに転用する(そのまま使ったり別物にカスタムしたりします)ので、他社が拡張できる余地を残しているのでしょう。

グラフィックボードのVRMフェーズ数は、よく「x+y」で表されます。

「GPUチップ用フェーズ+VRAMチップ用フェーズ」の意味です。

RTX 4090のリファレンスモデルなら「20+3」になります。

じゃあ23でいいじゃんってなるけどそういうことじゃないってことですね。この表記法は昔から初見殺しだと密かに思っている

VRMフェーズの数は、リファレンスモデルとオリジナルモデルで違います。

そのオリジナルモデルによっても大きく差があります。

同じRTX 4090でも「INNO3D GEFORCE RTX 4090 ICHILL X3 OC」は14+3なのに対して、「MSI RTX 4090 Suprim X」は26+4です。

リファレンスモデルに対して、GPU側が±6フェーズも違うオリジナルモデルがあります。

VRMフェーズが多ければ製造コストも上がるので、値段による差異はこの辺に表れてきます。

vBIOSやヒートシンクやファンなどにも優劣は生まれるので、VRMフェーズだけでは判断できませんが

ちなみにマザーボードだと「CPU+メモリ+その他」か「CPU+メモリ」のどちらかの表記です。

VRMフェーズから見る良グラボの簡易判定方法

VRMフェーズ数は比較的簡単に分かりますし、ネット上のどこかに情報が転がっていることも多いです。

オリジナルモデルのVRMフェーズを調べて性能を判断したいときはVRMフェーズ1個あたりにかかる電力を概算して判断してもいいと思います。

20+3なら、GPU側は380W/20=19Wで、VRAM側は75W/3=25Wということですね。

私には、マザーボードのVRMフェーズもグラボのVRMフェーズも25W以下なら問題ないという謎の自論があります。

GPUやVRAMなどの各モジュールごとの消費電力が分からない場合は、GPU側はTGP×0.9(つまり450W×0.9=405W)として、405W/20=20.25Wとかで雑計算して25W以下なら問題ないという認定をします。

VRAM側はグラボによってチップ数が違って計算が面倒なので思い切って無視です。

大事なことなので書きますが、25W以下という数値に根拠はありません。

ただ実際に計算してみると、18~25Wに収まることが多いのです。

MOSFETの性能も考慮すべきなので本当は雑どころの話ではないのですが、調べやすくて計算しやすいのでおすすめです。(マザーボードとかグラボとか買うときにMOSFETの型番とか普通調べんでしょ)

RTX 4090のVRAMチップはリファレンスもオリジナルも同じ

TechPowerUpの記事や基板から読み取れる情報がもう1つあります。

RTX 4090にはMicronのGDDR6X製品「MT61K512M32KPA-21:U」(FBGA Code:D8BZC)が採用されていて、2GBのVRAMチップが12個ある、ということです。

RTX 4090のVRAM容量は24GBと定められているのと、GDDR6Xの供給はMicronのみなので、GDDR6XであるVRAMチップにメーカーごとの違いは起こり得ません。

VRAM全体の消費電力が75Wとすると、GDDR6Xは1チップ辺り6.25W消費する計算です。

実測値で確認されているのは72Wまでなので、実際は6Wと認識していいでしょう。

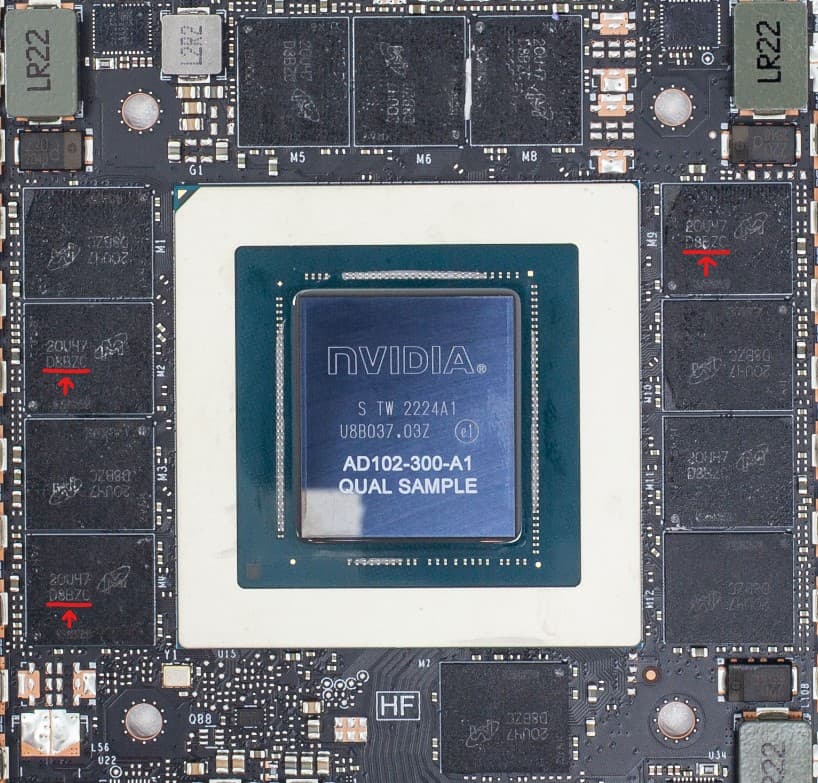

MOSFETsの性能

基板の画像を拝借させていただいたTechPowerUpの記事ですが、記事を読むとVRMフェーズにはGPU側とVRAM側ともに「MP86957」というDrMOS(MOSFET)が使われていることが分かります。

ちなみにTechPowerUpはGPU-ZやMemTest64の開発元で有名です

記事の中にも記載はありますが、MP86957の製品ページから最大70Aの電流を出力できることも分かります。

1つのVRMフェーズには1つのMOSFETを含むため、GPUチップ側は70A×20=1400A、VRAMチップ側は70A×3=210Aの電流が流せるわけです。

ちなみにMOSFETはリファレンスとオリジナルで違うので、流せる電流の大きさにはモデルごとに優劣があります。

例は少ないものの、マザーボードの製品ページにはVRMフェーズ数が書いてあることがあります。しかし、私はグラボの製品ページに書いてあるのを見たことがありません。

「オリファンのグラボならどのメーカーを買っても同じ」などと言われるのはこういう変態じみた情報を確認しないとメーカーごとの違いがよく分からないからです。

大容量フェーズ使ってる製品なら自らアピールして良いと思うんですが、そういうわけにはいかない大人の事情でもあるんですかね?(製造時期によってMOSFETやフェーズ数を変えてたりするのかもね)

電流が分かったなら、あとはGPUチップとVRAMチップの電圧と電力を知りたいところですね。

VRMフェーズが出力できる電力

CPUと同様にGPUも処理負荷によって電圧が動的に変わります。

TechPowerUpの検証によればRTX 4090のGPUチップ「AD102」は0.87V~1.05Vの範囲で動作し、最高負荷時は1.05Vになります。

消費電力の参考にしたThe FPS Reviewのレビュー記事でも、GPUチップの電圧は1.05Vでした。

GDDR6Xの電圧は1.35VとMicronのページに記載があります。

GPUが1.05V、VRAMが1.35Vですね。

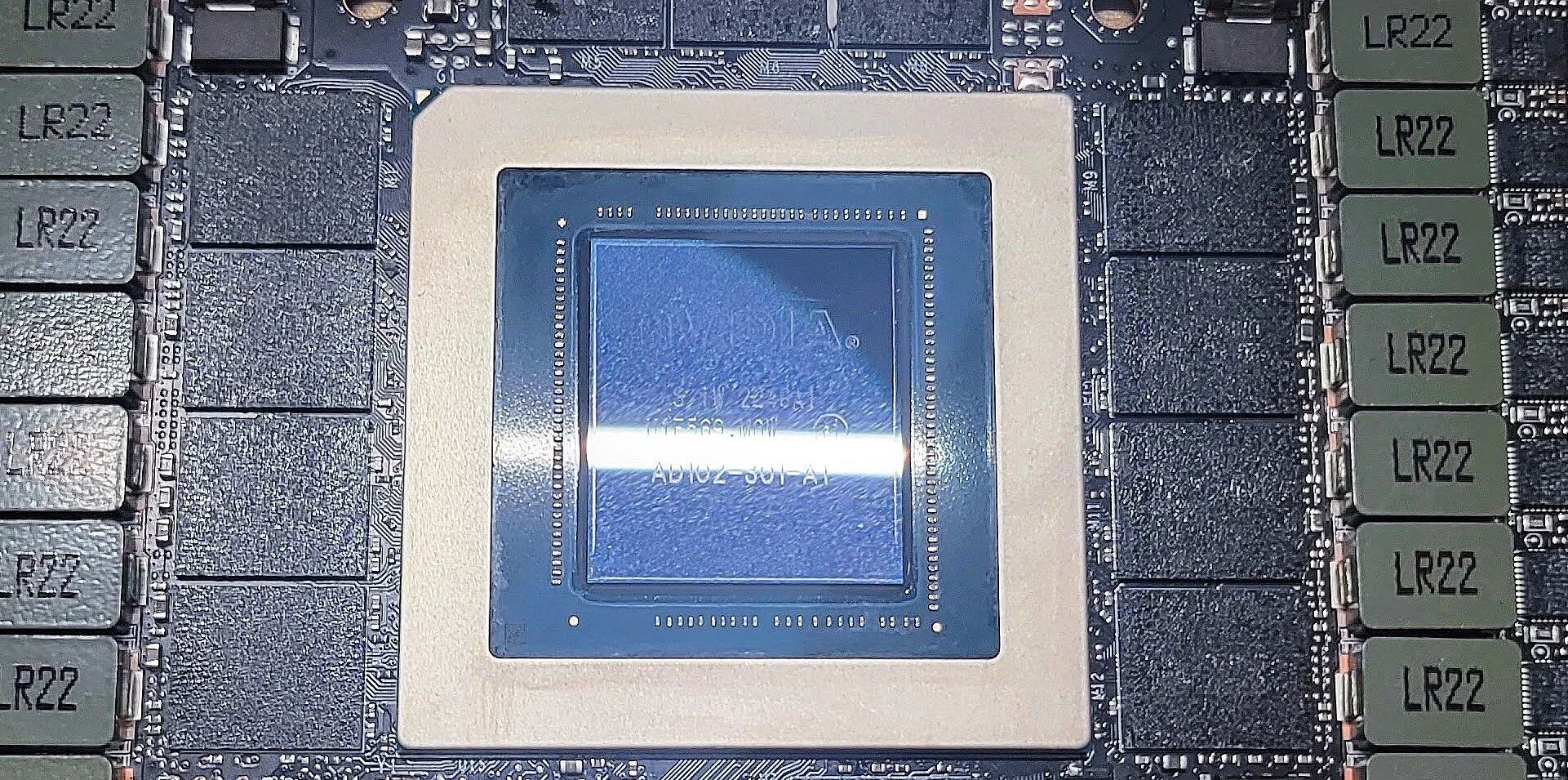

AD102の最大電圧は製造時期で異なる?

最大電圧は1.05Vよりも上です。

電力制限を解除したりオーバークロックを行ったりすると到達するのでしょう。

AD102の最大電圧は1.07~1.1Vです。

なぜ振れ幅があるのかというと、AD102には「AD102-300」と「AD102-301」の2つがあるからです。

初期型はAD102-300だったものの、途中からAD102-301に変更されて少し話題になりました。

何が変わったかというと、最大1.1Vだったのが最大1.07Vに下がったことです。

これによってオーバークロックの限界値が下がることが予想されます。

少し話題になったというのは、少し悪い意味で話題になったということです。

記事中では「リファレンスモデルのみの変更である可能性もある」とされていますが、真相は不明です。

上述の通り、電流はGPUが1400A、VRAMは210Aです。

電流と電圧が分かれば電力が分かります。

「電圧(V)×電流(A)=電力(W)」のアレですね。

今回はこれが出力可能な電力になる計算です。

消費電力については最大でGPUは380W程度、VRAMは75W程度であることが既に分かっています。

よく分かりませんが、これにちょっと余裕を持たせた感じになっているのでしょう。

あれ? なんか違和感が……

まあええか。よっしゃ計算したろ!w

GPU:1.05V×1400A=1470W

VRAM:1.35V×210A=283.5W

!?

デカ過ぎんだろ…

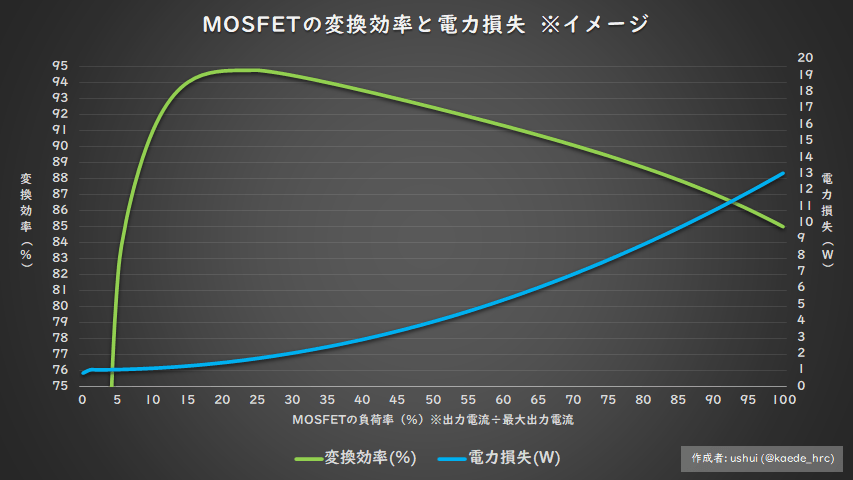

MOSFETの最大変換効率は、負荷が20~30%のとき

マザーボードの記事ですが、以下にMOSFETの変換効率について記載があります。

フェーズ数を増やすことで実装するパーツ数が増えるため、コストだけでなく不良が発生する確率も高くなります。またMOSFETには20~30%の負荷が最も変換効率が高くなる特性があります。つまり50A/10フェーズの電源回路だと、電圧は通常2Vで計算するため最大1,000Wまで出力できるわけです。そうすると最も効率的な運用ができるのは200~300Wということで、定格運用であればブースト時でも全く問題ありません。

20分で聞いた:勝負に勝つゲーミング機能を搭載したASRock Intel 500シリーズ - エルミタージュ秋葉原

MP86957のデータシートとか他のMOSFET関連の資料を見る限りでは大体こんな感じ。

もちろんグラフはMOSFETによって違うので注意。

グラフを見ると、変換効率が良いのは20~30%の負荷時であることが分かります。

仮に50%の負荷であった場合は概ね4Wの電力損失が発生するので、合計23フェーズなら4W*23=92W無駄に電力を使う計算です。

試しに0.2~0.3を掛けてみましょう。

1470Wは294~441W、

283.5Wは56.7~85.05Wになります。

次に0.25で掛けてみましょう。辻褄が合ってきます。

1470W×0.25=367.5Wで、283.5W×0.25=70.875Wになります。

実測値はGPUが380W程度、VRAMが75W程度なので、かなり近似しています。

恐らくはMOSFETの負荷が25%程度になるようにしているのでしょう。

25%なら概ね2Wの電力損失なので、損失分は46Wで済みます。

最も消費電力が高くなるときに最も変換効率が高くなるように設計されていることが分かります。

30%を超えた辺りから徐々に変換効率が悪くなって電力損失が増えるので、本来は不要な消費電力が増えて、かつ、電力損失分は熱に変換されてMOSFETの発熱に繋がります。

MOSFETは温度が上がると特性が変わるため、GPUやVRAMに対する安定した電源供給が難しくなってしまいます。

実際には電力制限を解除することで450Wから600WまでTGPを引き上げることが可能なので、その場合は違った結果になりますが、それでも30%を大きく超えるようなことはないでしょう。

電源ユニットは負荷が50%のときが最も変換効率が高いことは有名な話です。

そう考えれば受け入れやすい話だと思いました。

違った観点から見ると、TGP450Wに対して、GPUは約82%、VRAMは約16%を占める設計になっているという見方もできますね。

もし電力制限を解除して600Wにした場合はGPU側の比重が高くなると思います。

まとめ

グラフィックボードのオリジナルモデルのVRMフェーズやMOSFETを調べているうちに、リファレンスモデルの分解レビュー記事を目にして、なぜこの仕様になっているのか気になって調べました。

上手いこと設計されてるんだなぁと思ったのと同時に、グラフィックボードを買う前にこんなことをわざわざ調べてられんよねとも思いました。

グラフィックボードがリファレンスモデルだけなら、わざわざ調べる必要はありません。

リファレンスモデルを買う人は少数派でしょうし、オリジナルモデルが山ほどある中で優劣を知るなら内部仕様を調べる必要があります。

これらの仕様を最初から公表してくれればいいんですが、詳細を公表すると製造期間中は絶対にその部品を採用しなければならなくなったり(部品が供給できなくなったらアウト)、リファレンスよりも良いスペックにしなければならないという印象をオリジナルモデルのメーカーに植え付けたりすることになるので、恐らく商流上の理由から公表していないのだろうと解釈しています。

「MOSFETは20~30%が一番効率がいい」というのは初めて知ったのですが、裏を返せば20%未満も効率が良くないので「電力制限をする場合はVRMフェーズの数や性能が高すぎても良くない」ということになります。

「電源ユニットの電源容量2倍は多すぎ論」と同じような感じです。

もっとも、20%未満ならそもそもの消費電力が少ないので深く気にするべきではないのかもしれませんが

RTX 4090は60%の電力制限を行っても6%しか性能が落ちないので、電力制限は節電・発熱防止・ファンの騒音防止目的で有用です。

基本的にVRMフェーズは多い方がいいのですが、電力制限をするならあえてVRMフェーズが少ないモデルを狙うのもアリかもしれません。